2022年全国职业院校技能大赛高职组 大数据技术与应用赛项模拟赛题(Word版)

展开“大数据技术与应用”

赛项赛卷(5卷)

任

务

书

参赛队编号:

背景描述

大数据时代,电商经营模式发生很大改变。在传统运营模式中,缺乏数据积累,人们在做出一些决策行为过程中,更多是凭借个人经验和直觉,发展路径比较自我封闭。而大数据时代,为人们提供一种全新的思路,通过大量的数据分析得出的结果将更加现实和准确。商家可以对客户的消费行为信息数据进行收集和整理,比如消费者购买产品的花费、选择产品的渠道、偏好产品的类型、产品回购周期、购买产品的目的、消费者家庭背景、工作和生活环境、个人消费观和价值观等。通过数据追踪,知道顾客从哪儿来,是看了某网站投放的广告还是通过朋友推荐链接,是新访客还是老用户,喜欢浏览什么产品,购物车有无商品,是否清空,还有每一笔交易记录,精准锁定一定年龄、收入、对产品有兴趣的顾客,对顾客进行分组、标签化,通过不同标签组合运用,获得不同目标群体,以此开展精准推送。

因数据驱动的零售新时代已经到来,没有大数据,我们无法为消费者提供这些体验,为完成电商的大数据分析工作,你所在的小组将应用大数据技术,以Scala作为整个项目的基础开发语言,基于大数据平台综合利用Spark、Flink、Vue.js等技术,对数据进行处理、分析及可视化呈现,你们作为该小组的技术人员,请按照下面任务完成本次工作。

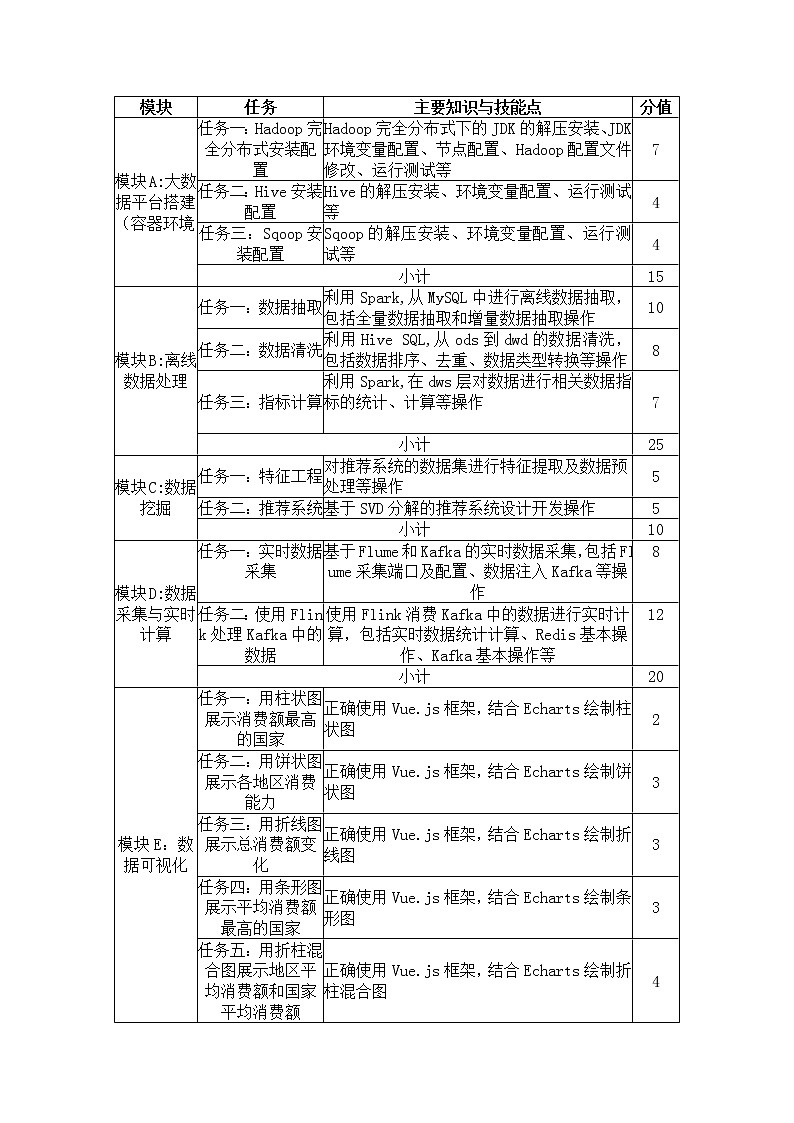

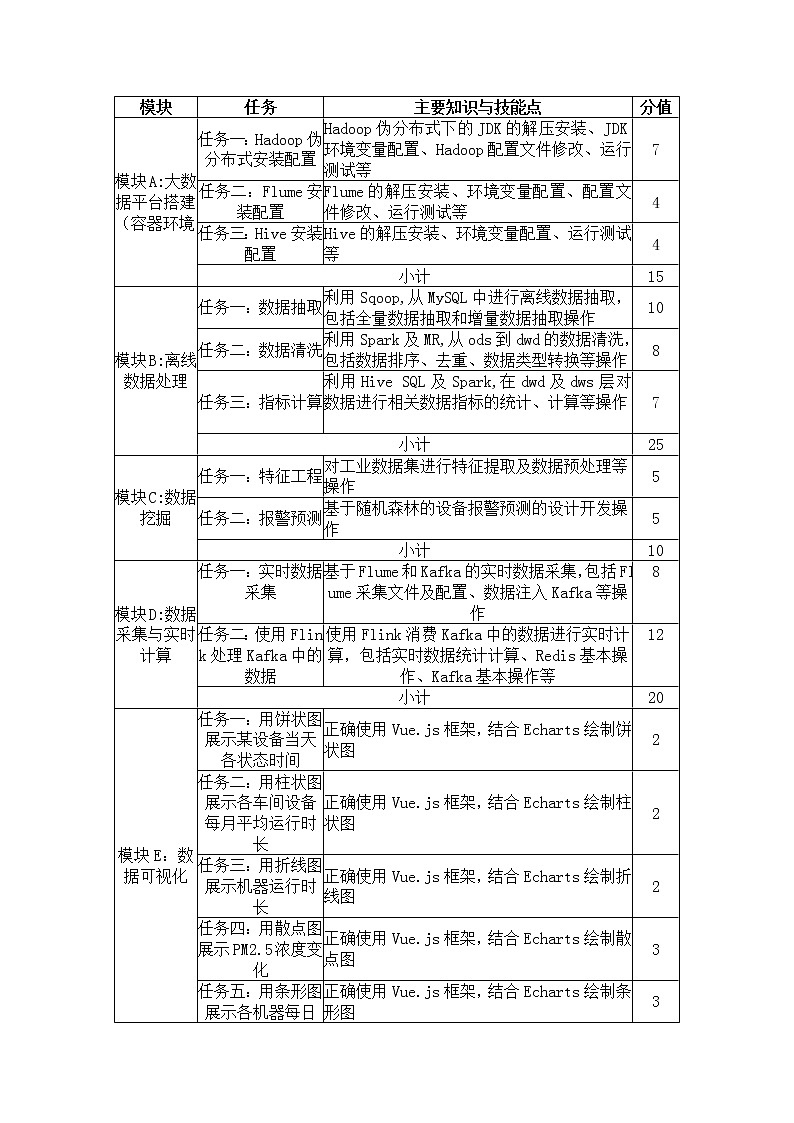

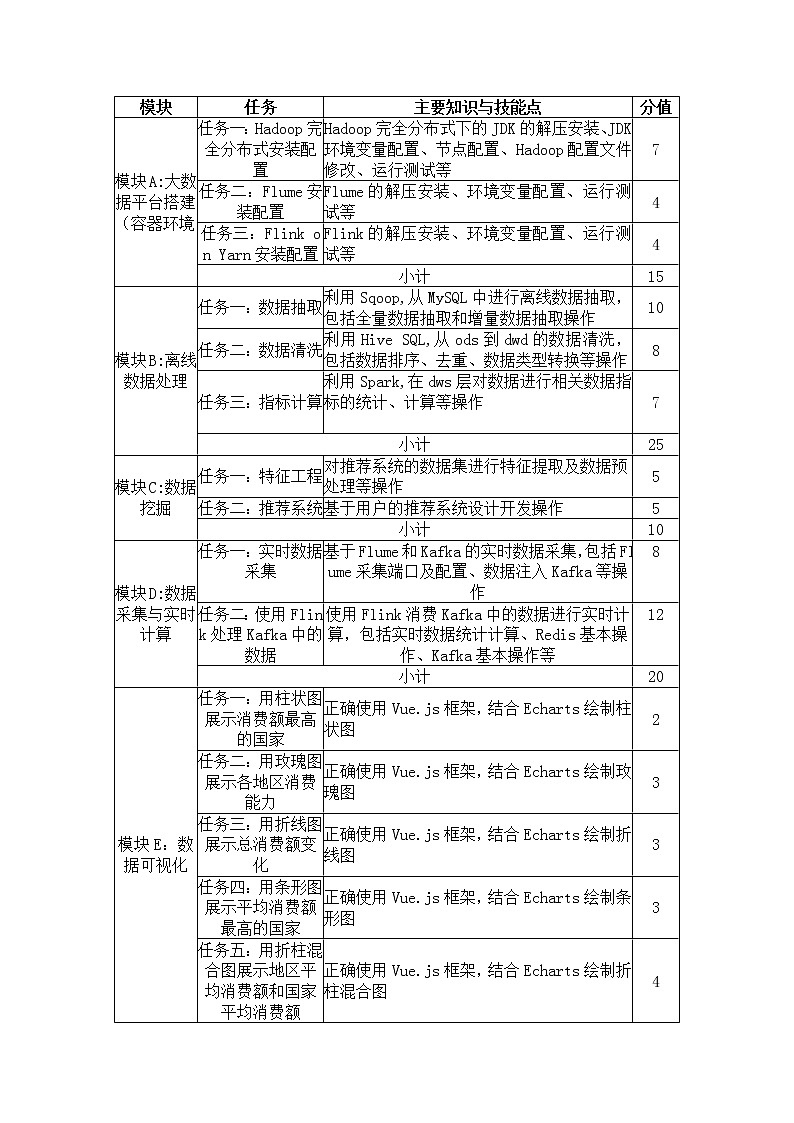

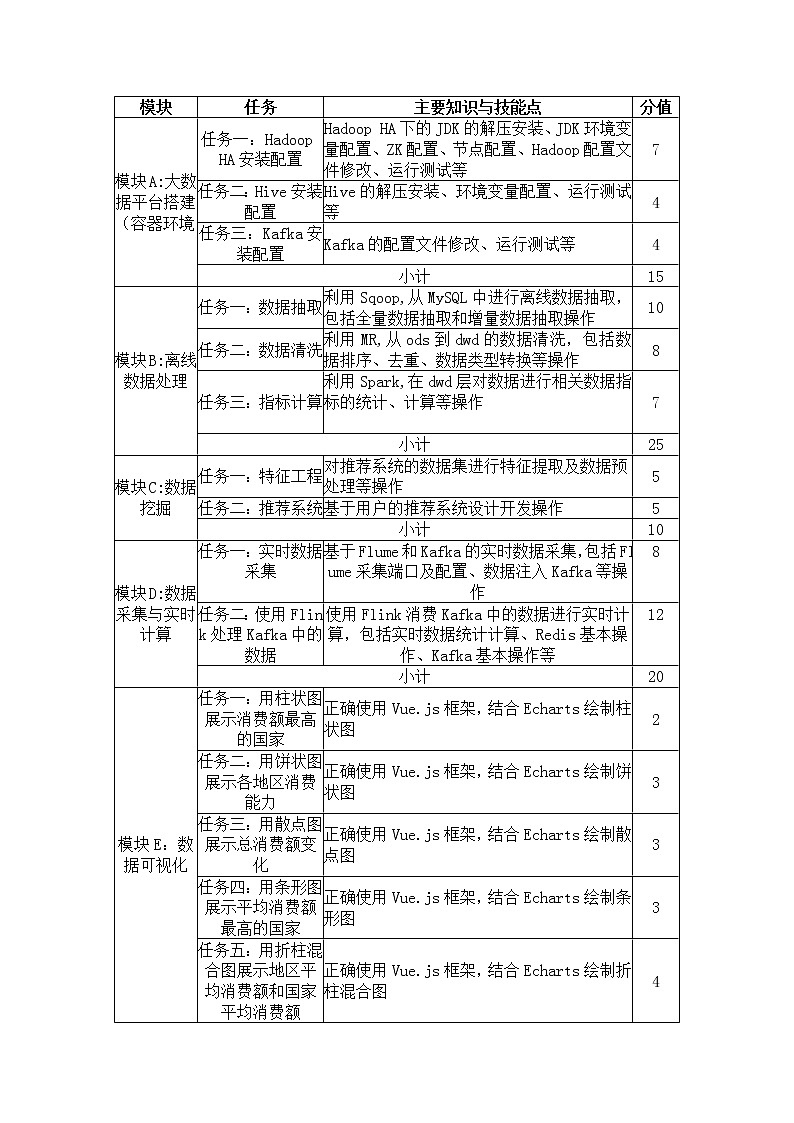

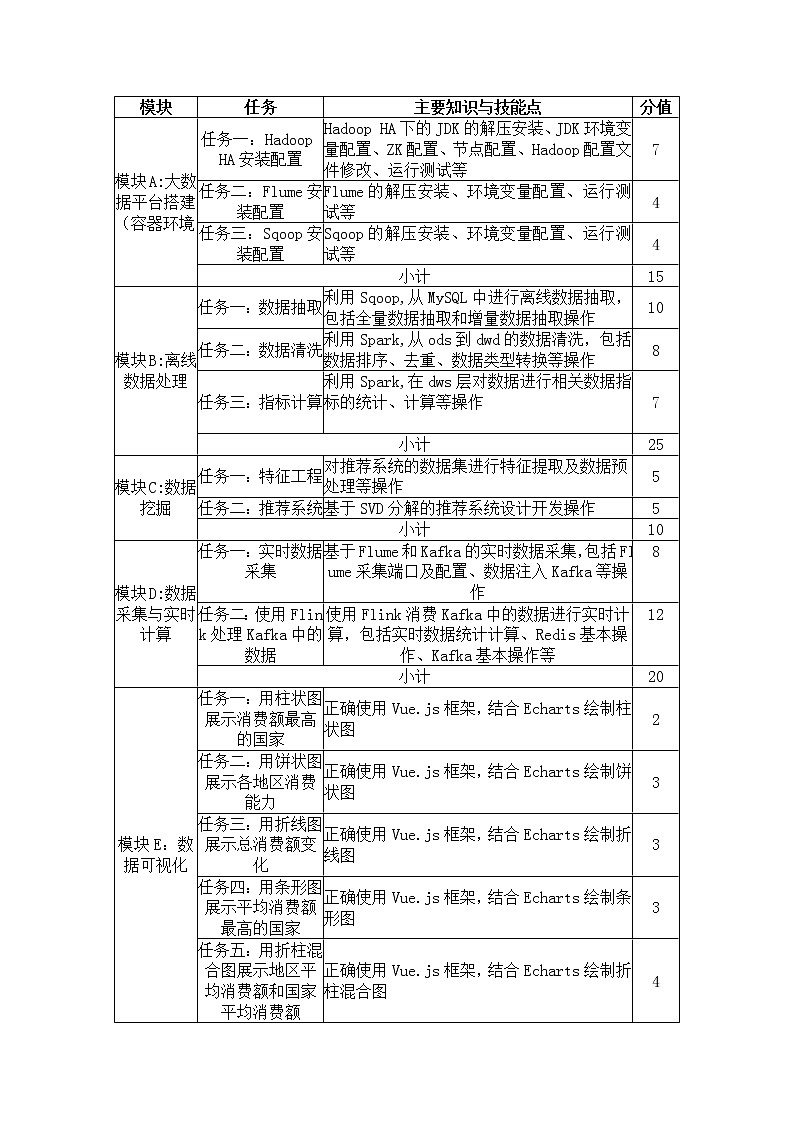

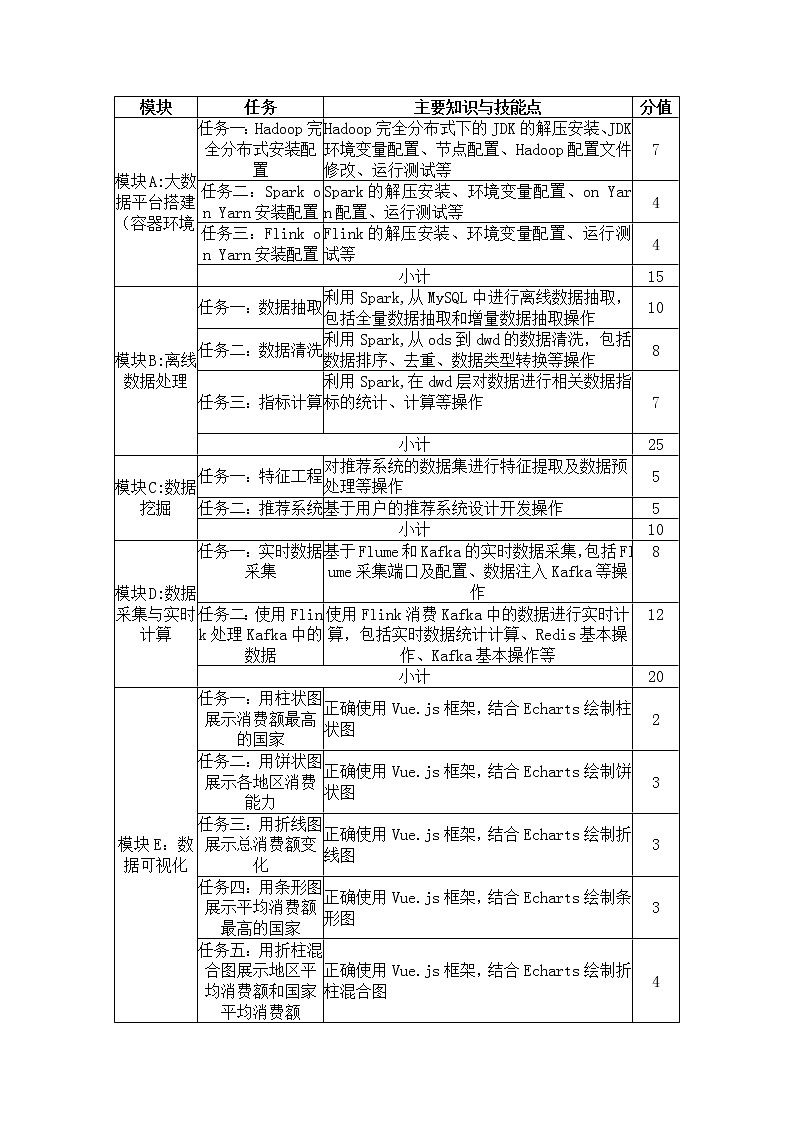

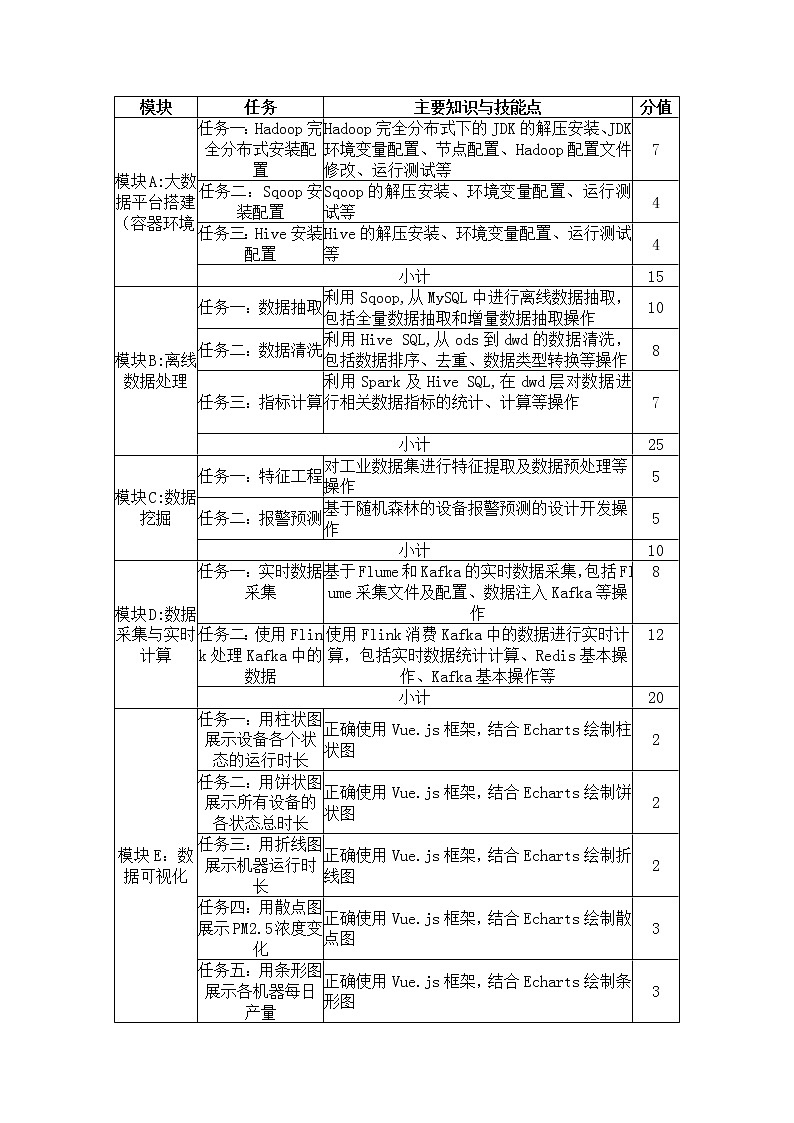

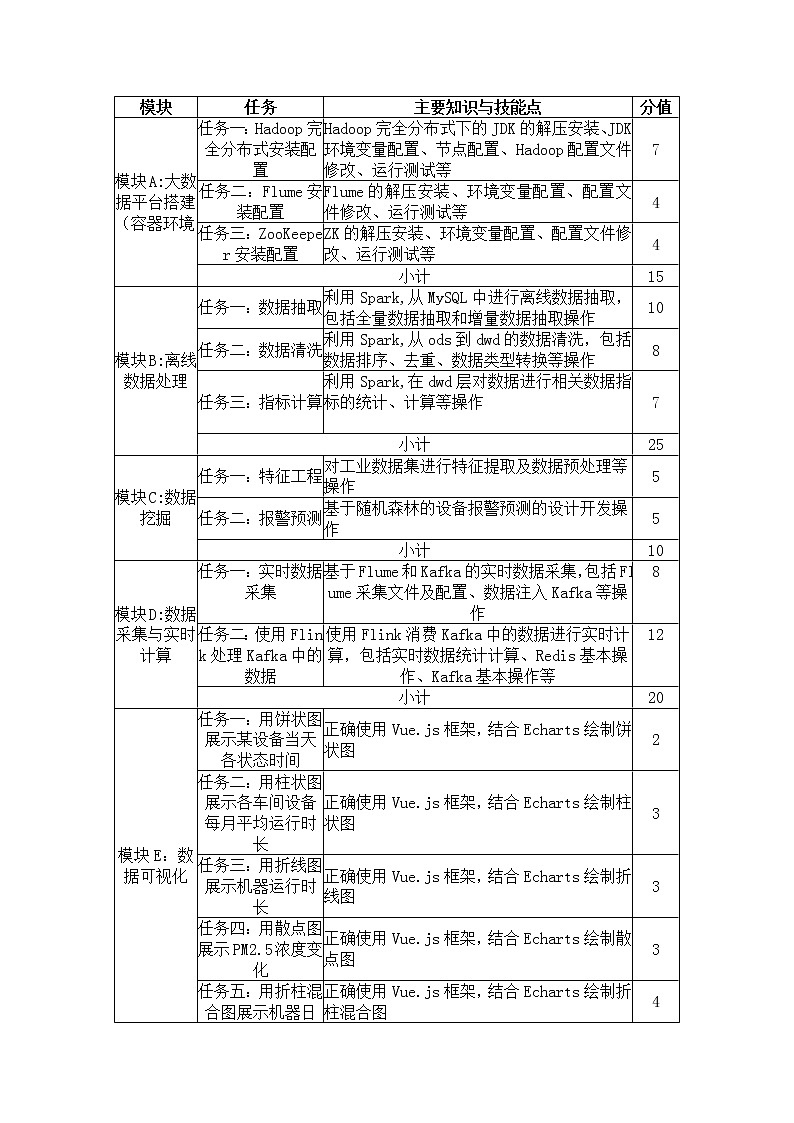

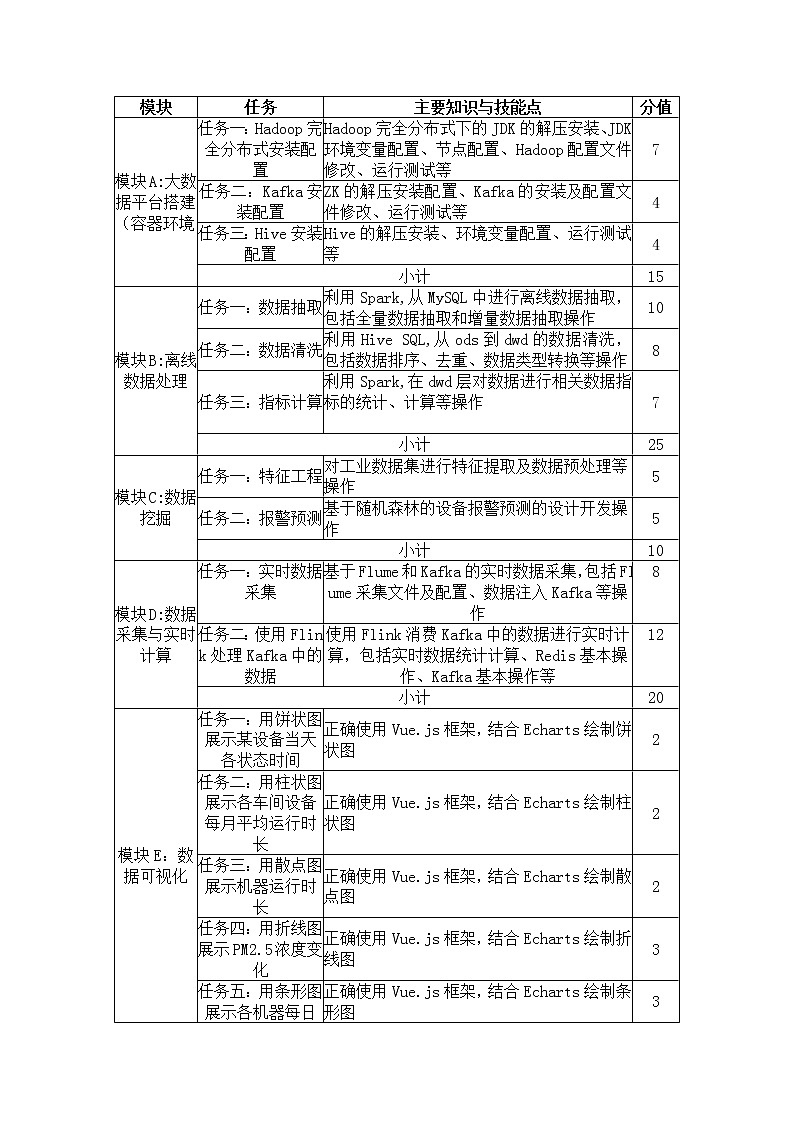

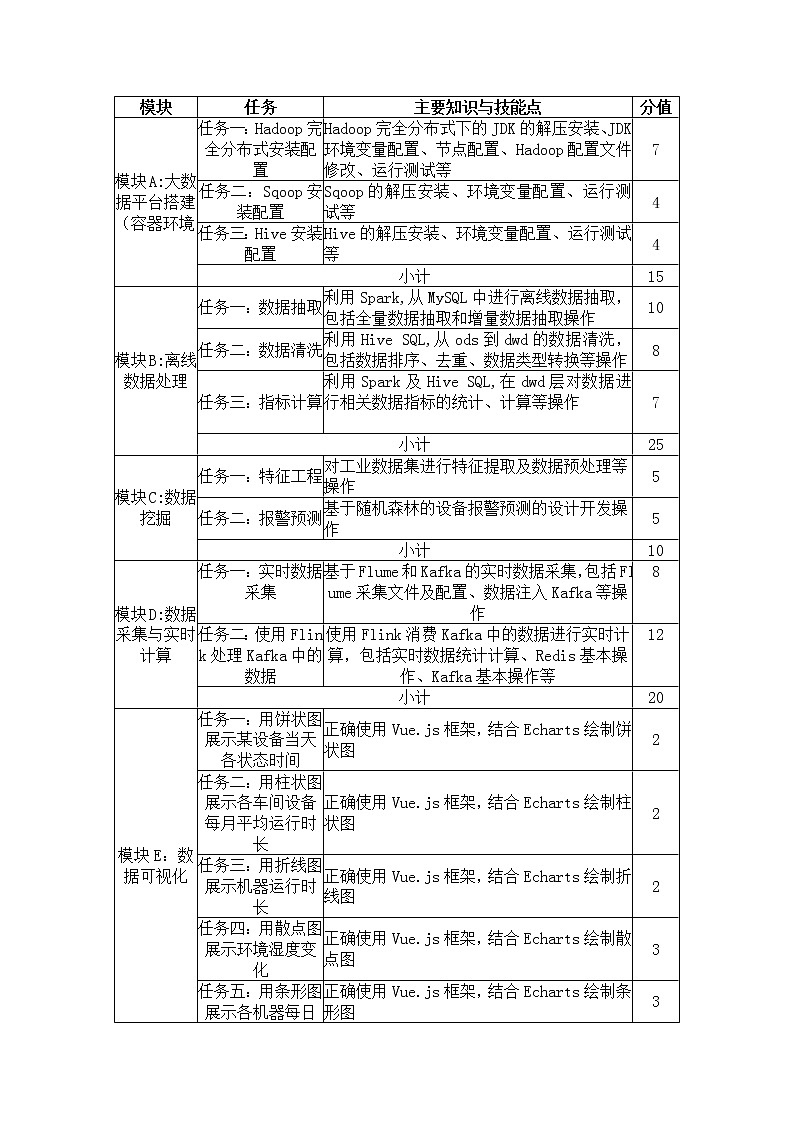

模块A:大数据平台搭建(容器环境)(15分)

环境说明:

任务一:Hadp HA安装配置

本环节需要使用rt用户完成相关配置,安装Hadp需要配置前置环境。命令中要求使用绝对路径,具体要求如下:

将Master节点JDK安装包解压并移动到/usr/lcal/src路径下,将命令复制并粘贴至对应报告中;

请完成hst相关配置,将三个节点分别命名为master、slave1、slave2,配置SSH免密登录,从Master节点复制JDK环境变量文件以及JDK解压后的安装文件到Slave1、Slave2节点,配置java环境变量,配置完毕后在Master节点分别执行“java”和“javac”命令,将命令行执行结果分别截图并粘贴至对应报告中;

Zkeeper配置完毕后,分发Zkeeper,分别在3个节点启动Zkeeper,并在Slave2节点查看ZKeeper运行状态,将查看命令和结果复制并粘贴至对应报告中;

ZKeeper、Hadp HA配置完毕后,请将设置为nn1,nn2并在Master节点启动Hadp,并查看服务(nn1,nn2)进程状态,并将查看命令及结果复制并粘贴至对应报告中;

Hadp HA配置完毕后,在Slave1节点查看服务进程,将查看命令及结果复制并粘贴至对应报告中。

任务二:Flume安装配置

本环节需要使用rt用户完成相关配置,已安装Hadp及需要配置前置环境,具体要求如下:

设置Flume环境变量,并使环境变量只对当前rt用户生效,将变量内容复制并粘贴至对应报告中;

完善相关配置,监控Hadp的namende日志,传输到HDFS的是/tmp/flume目录,将cnf-file中的修改内容复制并粘贴至对应报告中;

启动Flume传输Hadp日志,查看HDFS中/tmp/flume目录下生成的文件,将查看命令及结果(至少10条结果)复制并粘贴至对应报告中。

任务三:Sqp安装配置

本环节需要使用rt用户完成相关配置,已安装Hadp及需要配置前置环境,具体要求如下:

将Master节点Sqp安装包解压,修改解压后文件夹名为sqp并移动到/usr/lcal/src路径下,将全部命令复制粘贴至对应报告中;

完善相关配置,修改Sqp环境变量,并使环境变量只对当前rt用户生效,并将环境变量修改内容复制粘贴至对应报告中;

测试Sqp连接Master节点的MySQL数据库是否成功并展示所有的database,并将连接命令复制粘贴至对应报告中。

模块B:离线数据处理(25分)

环境说明:

任务一:数据抽取

使用Sqp工具,将MySQL的shtd_stre库中表CUSTOMER、NATION、PART、PARTSUPP、REGION、SUPPLIER的数据全量抽取到Hive的ds库中对应表custmer,natin,part,partsupp,regin,supplier中,将表ORDERS、LINEITEM的数据增量抽取到Hive的ds库中对应表ORDERS,LINEITEM中。

抽取shtd_stre库中CUSTOMER的全量数据进入Hive的ds库中表custmer。字段排序、类型不变,同时添加静态分区,分区字段类型为String,且值为当前比赛日的前一天日期(分区字段格式为yyyyMMdd)。并在hive cli执行shw partitins ds.custmer命令,将Sqp提交命令及hive cli的执行结果分别截图复制粘贴至对应报告中;

抽取shtd_stre库中NATION的全量数据进入Hive的ds库中表natin。字段排序、类型不变,同时添加静态分区,分区字段类型为String,且值为当前比赛日的前一天日期(分区字段格式为yyyyMMdd)。并在hive cli执行shw partitins ds.natin命令,将Sqp提交命令及hive cli的执行结果分别截图复制粘贴至对应报告中;

抽取shtd_stre库中PART的全量数据进入Hive的ds库中表part。字段排序、类型不变,同时添加静态分区,分区字段类型为String,且值为当前比赛日的前一天日期(分区字段格式为yyyyMMdd)。并在hive cli执行shw partitins ds.part命令,将Sqp提交命令及hive cli的执行结果分别截图复制粘贴至对应报告中;

抽取shtd_stre库中PARTSUPP的全量数据进入Hive的ds库中表partsupp。字段排序、类型不变,同时添加静态分区,分区字段类型为String,且值为当前比赛日的前一天日期(分区字段格式为yyyyMMdd)。并在hive cli执行shw partitins ds.partsupp命令,将Sqp提交命令及hive cli的执行结果分别截图复制粘贴至对应报告中;

抽取shtd_stre库中REGION的全量数据进入Hive的ds库中表regin。字段排序、类型不变,同时添加静态分区,分区字段类型为String,且值为当前比赛日的前一天日期(分区字段格式为yyyyMMdd)。并在hive cli执行shw partitins ds.regin命令,将Sqp提交命令及hive cli的执行结果分别截图复制粘贴至对应报告中;

抽取shtd_stre库中SUPPLIER的全量数据进入Hive的ds库中表supplier。字段排序、类型不变,同时添加静态分区,分区字段类型为String,且值为当前比赛日的前一天日期(分区字段格式为yyyyMMdd)。并在hive cli执行shw partitins ds.supplier命令,将Sqp提交命令及hive cli的执行结果分别截图复制粘贴至对应报告中;

抽取shtd_stre库中ORDERS的增量数据进入Hive的ds库中表rders,要求只取某年某月某日及之后的数据(包括某年某月某日),根据ORDERS表中ORDERKEY作为增量字段(提示:对比MySQL和Hive中的表的ORDERKEY大小),只将新增的数据抽入,字段类型不变,同时添加动态分区,分区字段类型为String,且值为ORDERDATE字段的内容(ORDERDATE的格式为yyyy-MM-dd,分区字段格式为yyyyMMdd),。并在hive cli执行select cunt(distinct(dealdate)) frm ds.rders命令,将Sqp提交命令及hive cli的执行结果分别截图复制粘贴至对应报告中;

抽取shtd_stre库中LINEITEM的增量数据进入Hive的ds库中表lineitem,根据LINEITEM表中rderkey作为增量字段,只将新增的数据抽入,字段类型不变,同时添加静态分区,分区字段类型为String,且值为当前比赛日的前一天日期(分区字段格式为yyyyMMdd)。并在hive cli执行shw partitins ds.lineitem命令,将Sqp提交命令及hive cli的执行结果分别截图复制粘贴至对应报告中。

任务二:数据清洗

编写Scala工程代码,将ds库中相应表数据全量抽取到Hive的dwd库中对应表中。表中有涉及到timestamp类型的,均要求按照yyyy-MM-dd HH:mm:ss,不记录毫秒数,若原数据中只有年月日,则在时分秒的位置添加00:00:00,添加之后使其符合yyyy-MM-dd HH:mm:ss。

将ds库中custmer表数据抽取到dwd库中dim_custmer的分区表,分区字段为etldate且值与ds库的相对应表该值相等,并添加dwd_insert_user、dwd_insert_time、dwd_mdify_user、dwd_mdify_time四列,其中dwd_insert_user、dwd_mdify_user均填写“user1”,dwd_insert_time、dwd_mdify_time均填写操作时间,并进行数据类型转换。在hive cli中按照cust_key顺序排序,查询dim_custmer前1条数据,将结果内容复制粘贴至对应报告中;

将ds库中part表数据抽取到dwd库中dim_part的分区表,分区字段为etldate且值与ds库的相对应表该值相等,并添加dwd_insert_user、dwd_insert_time、dwd_mdify_user、dwd_mdify_time四列,其中dwd_insert_user、dwd_mdify_user均填写“user1”,dwd_insert_time、dwd_mdify_time均填写操作时间,并进行数据类型转换。在hive cli中按照part_key顺序排序,查询dim_part前1条数据,将结果内容复制粘贴至对应报告中;

将ds库中natin表数据抽取到dwd库中dim_natin的分区表,分区字段为etldate且值与ds库的相对应表该值相等,并添加dwd_insert_user、dwd_insert_time、dwd_mdify_user、dwd_mdify_time四列,其中dwd_insert_user、dwd_mdify_user均填写“user1”,dwd_insert_time、dwd_mdify_time均填写操作时间,并进行数据类型转换。在hive cli中按照natin_key顺序排序,查询dim_natin前1条数据,将结果内容复制粘贴至对应报告中;

将ds库中regin表数据抽取到dwd库中dim_regin的分区表,分区字段为etldate且值与ds库的相对应表该值相等,并添加dwd_insert_user、dwd_insert_time、dwd_mdify_user、dwd_mdify_time四列,其中 dwd_insert_user、dwd_mdify_user均填写“user1”,dwd_insert_time、dwd_mdify_time均填写操作时间,并进行数据类型转换。在hive cli中按照regin_key顺序排序,查询dim_regin表前1条数据,将结果内容复制粘贴至对应报告中;

将ds库中rders表数据抽取到dwd库中fact_rders的分区表,分区字段为etldate且值与ds库的相对应表该值相等,并添加dwd_insert_user、dwd_insert_time、dwd_mdify_user、dwd_mdify_time四列,其中dwd_insert_user、dwd_mdify_user均填写“user1”,dwd_insert_time、dwd_mdify_time均填写操作时间,并进行数据类型转换。在执行hive cli执行select cunt(distinct(dealdate)) frm dwd.fact_rders命令,将结果内容复制粘贴至对应报告中;

待任务5完成以后,需删除ds.rders中的分区,仅保留最近的三个分区。并在hive cli执行shw partitins ds.rders命令,将结果截图粘贴至对应报告中;

将ds库中lineitem表数据抽取到dwd库中fact_lineitem的分区表,分区字段为etldate且值与ds库的相对应表该值相等,抽取的条件为根据rderkey和partkey进行去重,并添加dwd_insert_user、dwd_insert_time、dwd_mdify_user、dwd_mdify_time四列,其中dwd_insert_user、dwd_mdify_user均填写“user1”,dwd_insert_time、dwd_mdify_time均填写操作时间,并进行数据类型转换。在hive cli执行shw partitins dwd.fact_lineitem命令,将结果截图粘贴至对应报告中。

任务三:指标计算

编写Scala代码使用Spark引擎,并计算相关指标。

根据dwd层表统计每人每天下单的数量和下单的总金额,存入dws层的custmer_cnsumptin_day_aggr表(表结构如下)中,然后在hive cli中按照cust_key,ttalcnsumptin, ttalrder三列均逆序排序的方式,查询出前5条,将SQL语句与执行结果截图粘贴至对应报告中;

根据dws层表custmer_cnsumptin_day_aggr统计连续两个月下单并且下单金额保持增长的用户,订单发生时间限制为大于等于某年,存入MySQL数据库shtd_stre的usercntinuerder表(表结构如下)中。然后在Linux的MySQL命令行中根据订单总数、消费总额、客户主键三列均逆序排序的方式,查询出前5条,将SQL语句与执行结果截图粘贴至对应报告中。

根据任务2的结果并结合表dim_natin与表custmer_cnsumptin_day_aggr,请计算每个国家连续两个月下单并且下单金额保持增长与该国已下单用户的占比,将结果存入MySQL数据库shtd_stre的userrepurchased表(表结构如下)中。然后在Linux的MySQL命令行中根据订单总数、消费总额、客户主键三列均逆序排序的方式,查询出前5条,将SQL语句与执行结果截图粘贴至对应报告中。

模块C:数据挖掘(10分)

环境说明:

任务一:特征工程

根据dwd库中fact_rders表,将其转换为以下表:第一列为用户id,其余列名为零部件id ,按照cust_key进行顺序排序,保存在hive的dwd.fact_cust_part_machinelearning _data中,然后在Hive cli中执行命令desc fact_cust_part_machinelearning 中查询出结果,将SQL语句与执行结果截图粘贴至对应报告中。

任务二:基于SVD分解的推荐系统

根据任务一的结果,对其进行SVD分解,对数据进行降维(保留95%以上的特征信息),根据该用户已购买的商品分别与未购买的商品计算余弦相似度再进行累加求均值,将结果最大的5件商品key进行输出作为推荐使用。将输出结果保存至MySQL的part_machine表中。然后在Linux的MySQL命令行中查询出前5条数据,将SQL语句与执行结果截图粘贴至对应报告中。

模块D:数据采集与实时计算(20分)

环境说明:

任务一:实时数据采集

在Master节点使用Flume采集实时数据生成器26001端口的scket数据,将数据存入到Kafka的Tpic中(tpic名称为rder,分区数为4),将Flume的配置截图粘贴至对应报告中;

Flume接收数据注入kafka 的同时,将数据备份到HDFS目录/user/test/flumebackup下,将备份结果截图粘贴至对应报告中。

任务二:使用Flink处理Kafka中的数据

编写Scala工程代码,使用Flink消费Kafka中Tpic为rder的数据并进行相应的数据统计计算。

使用Flink消费Kafka中的数据,统计个人实时订单总额,将key设置成ttalprice存入Redis中(再使用hash数据格式,key存放为用户id,value存放为该用户消费总额),使用redis cli以get key方式获取ttalprice值,将结果截图粘贴至对应报告中,需两次截图,第一次截图和第二次截图间隔一分钟以上,第一次截图放前面,第二次放后面。

在任务1进行的同时需监控若发现ORDERSTATUS字段为F,将数据存入MySQL表alarmdata中(可考虑侧边流的实现),然后在Linux的MySQL命令行中根据ORDERKEY逆序排序,查询出前5条,将SQL语句与执行结果截图粘贴至对应报告中;

使用Flink消费kafka中的数据,统计每分钟下单的数量,将key设置成ttalrder存入redis中。使用redis cli以get key方式获取ttalrder值,将结果粘贴至对应报告中,需两次截图,第一次截图(应该在jb启动2分钟数据稳定后再截图)和第二次截图时间间隔应达一分钟以上,第一次截图放前面,第二次放后面。(注:流数据中,时间未精确到时分秒,建议StreamTimeCharacteristic设置成PrcessingTime(默认)或IngestinTime。)

模块E:数据可视化(15分)

环境说明:

任务一:用柱状图展示消费额最高的国家

编写Vue工程代码,根据接口,用柱状图展示某年某月消费额最高的5个国家,同时将用于图表展示的数据结构在浏览器的cnsle中进行打印输出,将图表可视化结果和浏览器cnsle打印结果分别截图并粘贴至对应报告中。

任务二:用饼状图展示各地区消费能力

编写Vue工程代码,根据接口,用饼状图展示某年第一季度各地区的消费总额占比,同时将用于图表展示的数据结构在浏览器的cnsle中进行打印输出,将图表可视化结果和浏览器cnsle打印结果分别截图并粘贴至对应报告中。

任务三:用折线图展示总消费额变化

编写Vue工程代码,根据接口,用折线图展示某年上半年商城总消费额的变化情况,同时将用于图表展示的数据结构在浏览器的cnsle中进行打印输出,将图表可视化结果和浏览器cnsle打印结果分别截图并粘贴至对应报告中。

任务四:用条形图展示平均消费额最高的国家

编写Vue工程代码,根据接口,用条形图展示某年平均消费额最高的5个国家,同时将用于图表展示的数据结构在浏览器的cnsle中进行打印输出,将图表可视化结果和浏览器cnsle打印结果分别截图并粘贴至对应报告中。

任务五:用折柱混合图展示地区平均消费额和国家平均消费额

编写Vue工程代码,根据接口,用折柱混合图展示某年地区平均消费额和国家平均消费额的对比情况,柱状图展示平均消费额最高的5个国家,折线图展示每个国家所在的地区的平均消费额变化,同时将用于图表展示的数据结构在浏览器的cnsle中进行打印输出,将图表可视化结果和浏览器cnsle打印结果分别截图并粘贴至对应报告中。

模块F:综合分析(10分)

任务一:对于UDF/UDAF/UDTF理解

在模块B中可能会用到UDF/UDAF/UDTF,他们的区别是什么,请问他们分别解决了什么问题?将内容编写至对应报告中。

任务二:对于数据挖掘模块中的用户推荐有什么好的建议

在模块C中使用基于用户的推荐系统思路对用户的相似性进行计算,从而为每个用户推荐商品,你认为可以从哪些方面再进行优化?这种推荐策略对业务的发展会起到什么样的作用?将内容编写至对应报告中。

任务三:简要描述任务过程中的问题并进行总结

将内容编写至对应报告中。

服务端登录地址详见各模块服务端说明。

补充说明:宿主机可通过Asbru工具或SSH客户端进行SSH访问;

相关软件安装包在宿主机的/pt目录下,请选择对应的安装包进行安装,用不到的可忽略;

所有模块中应用命令必须采用绝对路径;

从本地仓库中拉取镜像,并启动3个容器

进入Master节点的方式为

dcker exec –it master /bin/bash

进入Slave1节点的方式为

dcker exec –it slave1 /bin/bash

进入Slave2节点的方式为

dcker exec –it slave2 /bin/bash

同时将/pt目录下的所有安装包移动到3个容器节点中。

服务端登录地址详见各模块服务端说明。

补充说明:各主机可通过Asbru工具或SSH客户端进行SSH访问;

Master节点MySQL数据库用户名/密码:rt/123456(已配置远程连接);

Hive的元数据启动命令为:

nhup hive --service metastre &

Hive的配置文件位于/pt/apache-hive-

Spark任务在Yarn上用Client运行,方便观察日志。

字段

类型

中文含义

备注

cust_key

int

客户key

cust_name

string

客户名称

ttalcnsumptin

duble

消费总额

当月消费订单总额

ttalrder

int

订单总数

当月订单总额

year

int

年

订单产生的年

mnth

int

月

订单产生的月

day

int

日

订单产生的日

字段

类型

中文含义

备注

custkey

int

客户主键

custname

text

客户名称

mnth

text

月

记录当前月和下月,用下划线‘_’相连

例如: 202201_202202

表示2022年1月到2月用户连续下单。

ttalcnsumptin

duble

消费总额

连续两月的订单总额

ttalrder

int

订单总数

连续两月的订单总数

字段

类型

中文含义

备注

natinkey

int

国家主键

natinname

string

国家名称

purchaseduser

int

下单人数

该国家内已下单人数

repurchaseduser

duble

连续下单人数

该国家内连续两个月下单并且下单金额保持增长人数

repurchaserate

int

占比

下单人数/连续下单人数(保留3位小数)

服务端登录地址详见各模块服务端说明。

补充说明:各主机可通过Asbru工具或SSH客户端进行SSH访问;

Master节点MySQL数据库用户名/密码:rt/123456(已配置远程连接);

Hive的元数据启动命令为:

nhup hive --service metastre &

Hive的配置文件位于/pt/apache-hive-

Spark任务在Yarn上用Client运行,方便观察日志。

该模块均使用Scala编写,利用Spark相关库完成。

字段

类型

中文含义

备注

cust_key

duble

客户key

partkey1

duble

用户是否购买过零部件1

若用户购买过该零部件,则值为1,否则为0

partkey2

duble

用户是否购买过零部件2

若用户购买过该零部件,则值为1,否则为0

partkey3

duble

用户是否购买过零部件3

若用户购买过该零部件,则值为1,否则为0

服务端登录地址详见各模块服务端说明。

补充说明:各主机可通过Asbru工具或SSH客户端进行SSH访问;

请先检查ZKeeper、Kafka、Redis端口看是否已启动,若未启动则各启动命令如下:

ZK启动(netstat -ntlp查看2181端口是否打开)

/usr/zk/zkeeper- start

Redis启动(netstat -ntlp查看6379端口是否打开)

/usr/redis/bin/redis-server /usr/redis/bin/redis.cnf

Kafka启动(netstat -ntlp查看9092端口是否打开)

/pt/kafka/kafka_2.11- -daemn(空格连接下一行)/pt/kafka/kafka_2.11-

Flink任务在Yarn上用per jb模式(即Jb分离模式,不采用Sessin模式),方便Yarn回收资源。

数据接口地址及接口描述详见各模块服务端说明。

2022年全国职业院校技能大赛高职组 移动应用开发赛项模拟赛题(Word版): 这是一份2022年全国职业院校技能大赛高职组 移动应用开发赛项模拟赛题(Word版),文件包含移动应用开发05docx、移动应用开发08docx、移动应用开发03docx、移动应用开发04docx、移动应用开发06docx、移动应用开发01docx、移动应用开发02docx、移动应用开发07docx、移动应用开发09docx、移动应用开发10docx等10份试卷配套教学资源,其中试卷共383页, 欢迎下载使用。

2022年全国职业院校技能大赛高职组 水处理技术赛项模拟赛题(Word版): 这是一份2022年全国职业院校技能大赛高职组 水处理技术赛项模拟赛题(Word版),文件包含模块A水处理工艺赛题库1docx、模块A水处理工艺赛题库6docx、模块A水处理工艺赛题库10docx、模块A水处理工艺赛题库8docx、模块A水处理工艺赛题库7docx、模块A水处理工艺赛题库9docx、模块A水处理工艺赛题库5docx、模块A水处理工艺赛题库4docx、模块A水处理工艺赛题库3docx、模块A水处理工艺赛题库2docx、模块B2泵站系统运行与维护赛题库10docx、模块B2泵站系统运行与维护赛题库8docx、模块B2泵站系统运行与维护赛题库7docx、模块B2泵站系统运行与维护赛题库6docx、模块B2泵站系统运行与维护赛题库5docx、模块B2泵站系统运行与维护赛题库4docx、模块B2泵站系统运行与维护赛题库3docx、模块B2泵站系统运行与维护赛题库2docx、模块B2泵站系统运行与维护赛题库1docx、模块B2泵站系统运行与维护赛题库9docx、模块B1水的混凝试验赛题库9doc、模块B1水的混凝试验赛题库8doc、模块B1水的混凝试验赛题库6doc、模块B1水的混凝试验赛题库4doc、模块B1水的混凝试验赛题库3doc、模块B1水的混凝试验赛题库2doc、模块B1水的混凝试验赛题库1doc、模块B1水的混凝试验赛题库10doc、模块B1水的混凝试验赛题库5doc、模块B1水的混凝试验赛题库7doc等30份试卷配套教学资源,其中试卷共469页, 欢迎下载使用。

2022年全国职业院校技能大赛高职组 嵌入式技术应用开发赛项模拟赛题(Word版): 这是一份2022年全国职业院校技能大赛高职组 嵌入式技术应用开发赛项模拟赛题(Word版),文件包含10-第二模块比赛任务流程表doc、08-第三模块比赛任务流程表docx、07-第二模块比赛任务流程表doc、07-第三模块比赛任务流程表docx、06-第二模块-比赛任务流程表doc、06-第三模块比赛任务流程表docx、01-第三模块比赛任务流程表docx、05-第二模块比赛任务流程表doc、05-第三模块比赛任务流程表docx、09-第三模块比赛任务流程表docx、04-第二模块比赛任务流程表doc、04-第三模块比赛任务流程表docx、09-第二模块比赛任务流程表doc、03-第二模块比赛任务流程表doc、03-第三模块比赛任务流程表docx、02-第二模块比赛任务流程表doc、02-第三模块比赛任务流程表docx、10-第三模块比赛任务流程表docx、01-第二模块比赛任务流程表doc、08-第二模块比赛任务流程表doc、10-第一模块比赛任务表docx、09-第一模块比赛任务表docx、01-第一模块比赛任务表docx、08-第一模块比赛任务表docx、07-第一模块比赛任务表docx、05-第一模块比赛任务表docx、04-第一模块比赛任务表docx、03-第一模块比赛任务表docx、02-第一模块比赛任务表docx、06-第一模块比赛任务表docx等30份试卷配套教学资源,其中试卷共80页, 欢迎下载使用。